AMD ha puesto una marcha más en la carrera de la inteligencia artificial con el lanzamiento oficial de ROCm 7, la última versión de su plataforma abierta para computación acelerada. Y esta vez no se trata solo de una mejora incremental: estamos ante un salto importante que multiplica el rendimiento y extiende el soporte a nuevos territorios, incluyendo por fin a usuarios de Windows y GPU Radeon.

Más potencia, más compatibilidad, más futuro

Uno de los titulares clave es el aumento de rendimiento: ROCm 7 promete acelerar las inferencias de IA hasta 3,5 veces más rápido que su predecesor. Y no es solo una promesa en el papel. AMD afirma que con su GPU Instinct MI300X, modelos tan exigentes como Llama 3.1-70B, Qwen 72B o Deepseek-R1 ahora corren con más soltura gracias a una optimización profunda del uso de la GPU y del movimiento de datos. Lo interesante es que el resto del hardware se mantuvo igual; el cambio estuvo solo en el software.

Esta mejora llega en un momento clave, ya que el talón de Aquiles de AMD frente a gigantes como NVIDIA no ha sido la potencia de sus chips, sino la madurez de su ecosistema de software. Con ROCm 7, parece que por fin se están nivelando las cartas.

Buenas noticias para usuarios de Radeon (y de Windows)

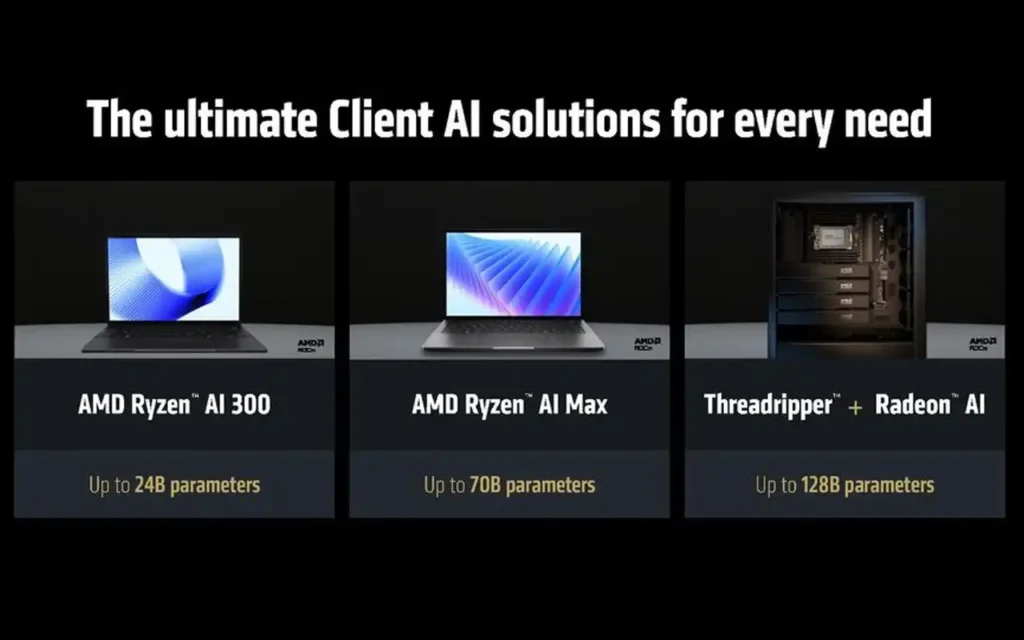

La gran sorpresa para los entusiastas del hardware viene con una apertura esperada: ROCm 7 se expande a GPUs Radeon y al sistema operativo Windows. Eso significa que quienes usen PC de escritorio o portátiles con procesadores Ryzen y gráficas Radeon (integradas o dedicadas) podrán ejecutar tareas de IA avanzadas sin depender de servidores en la nube ni de otras arquitecturas.

Este movimiento abre la puerta a algo muy esperado por la comunidad: correr modelos generativos y LLMs localmente, como ChatGPT o Copilot, en tu propio equipo. Eso sí, de momento, la compatibilidad está limitada a plataformas Ryzen, algo lógico si se piensa en la optimización cruzada entre CPU y GPU que tanto cuida AMD.

Preparados para el mañana: FP4, FP6 y la familia Instinct del futuro

En el terreno más técnico, pero con impacto real, ROCm 7 añade soporte para los formatos de precisión reducida FP4 y FP6, ideales para modelos de IA que necesitan velocidad y eficiencia energética sin sacrificar resultados. Esto se traduce en mejor desempeño para los nuevos procesadores Instinct MI350X y MI355X, así como para las próximas bestias de silicio de la serie MI400X y los futuros MI500X, previstos para 2026 y más allá.

En resumen: AMD está armando su ecosistema para competir no solo en el presente, sino en el futuro cercano de la IA acelerada.

Inteligencia distribuida y una nube al alcance de todos

Además del salto en rendimiento, AMD ha integrado compatibilidad con frameworks abiertos como vLLM, SGLang y llm-d, lo que permite escalar modelos de IA en múltiples GPU de forma más sencilla y eficiente. Esto es vital para aplicaciones empresariales donde la carga se reparte entre distintas tarjetas gráficas, algo que hasta hace poco era terreno exclusivo de otras plataformas.

Y como cereza del pastel, AMD lanza su Developer Cloud, un entorno en la nube que da acceso directo a configuraciones de alto rendimiento basadas en MI300X. Desde setups con una sola GPU y 192 GB de memoria hasta máquinas monstruosas de 8 vías y 1.5 TB de VRAM compartida. La buena noticia: todos los desarrolladores podrán probarla con 25 horas gratuitas.

ROCm Enterprise AI MLOps: el giro empresarial de AMD

Para las compañías que buscan soluciones llave en mano, llega ROCm Enterprise AI MLOps, un conjunto de herramientas que permite refinar modelos con datos propios, integrarlos en flujos de trabajo estructurados y acelerar el paso de prototipos a producción. Con aliados estratégicos, AMD está desarrollando plantillas para casos como chatbots o sistemas de resumen automático, reforzando su apuesta por el uso profesional de sus GPUs.